L'intelligence artificielle open source a une nouvelle star et son ascension est tout simplement fulgurante. En l'espace d'un mois seulement, un projet nommé Moltbot, anciennement connu sous le nom de Clawdbot, a dépassé la barre symbolique des 69 000 étoiles sur GitHub. Ce succès propulse l'outil créé par le développeur autrichien Peter Steinberger parmi les projets IA à la croissance la plus rapide de l'année. L'ambition de ce logiciel est de vous permettre de gérer un assistant personnel intelligent directement depuis les applications de messagerie que vous utilisez au quotidien. Pourtant, derrière l'engouement massif pour ce qui ressemble à l'assistant du futur, se cachent des risques de sécurité qu'il est nécessaire de comprendre avant de l'installer.

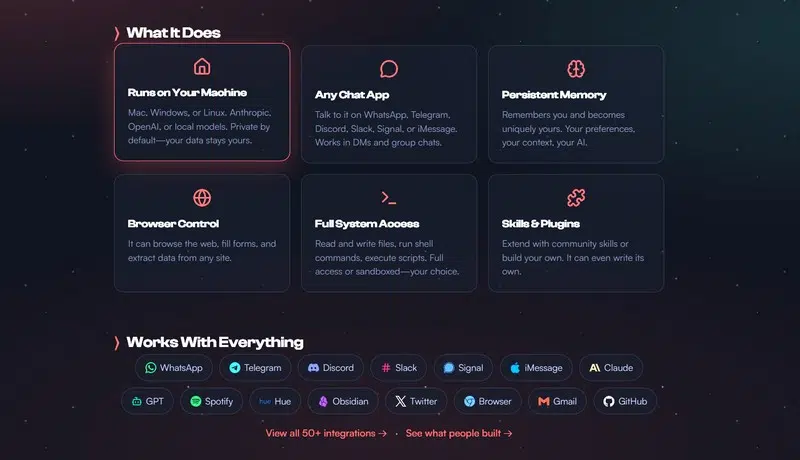

Moltbot se différencie de la pléthore de bots inactifs qui peuplent les dépôts de code, par sa capacité à prendre les devants grâce à une communication proactive. Loin d'être passif, l'assistant s'intègre à un vaste écosystème incluant WhatsApp, Telegram, Slack, Discord, Google Chat, Signal, iMessage ou encore Microsoft Teams. Il ne se contente pas de répondre aux questions, il peut vous contacter pour vous envoyer des rappels, des alertes ou des briefings matinaux basés sur votre calendrier. Cette faculté à gérer activement les tâches numériques a valu au projet des comparaisons flatteuses avec Jarvis, l'assistant mythique des films Iron Man.

Il séduit d'un point de vue technique par son approche hybride et sa mémoire. Bien que le code d'organisation tourne sur votre machine locale, garantissant une certaine rapidité, le cerveau de l'opération repose souvent sur des modèles puissants accessibles via abonnement, comme ceux d'OpenAI ou d'Anthropic. Claude Opus 4.5 est d'ailleurs un choix populaire pour piloter ce système. Contrairement à des outils comme Claude Code qui fonctionnent par session et oublient le contexte une fois fermés, Moltbot est conçu comme un démon d'arrière-plan fonctionnant 24h/24 et 7j/7. Il conserve une mémoire à long terme via des fichiers Markdown et une base de données SQLite, lui permettant de se souvenir de conversations datant de plusieurs semaines. L'expérience est similaire à l'utilisation de Claude, mais avec des mains, capable d'agir concrètement sur le navigateur ou les fichiers.

Cette puissance a malgré tout un prix, littéralement et figurativement. L'utilisation intensive d'un système aussi autonome, qui effectue de nombreux appels en arrière-plan, peut faire grimper la facture d'API très rapidement. De plus, l'installation n'est pas à la portée du premier venu. Elle nécessite la configuration d'un serveur, la gestion de l'authentification et une compréhension fine du "sandboxing" pour isoler l'IA du reste du système. C'est ici que le bât blesse. Donner à une IA un accès quasi illimité à sa vie numérique, y compris aux messageries et aux commandes shell, élargit considérablement la surface d'attaque potentielle pour des acteurs malveillants.

L'histoire récente du projet montre d'ailleurs la volatilité de cet écosystème. Baptisé dans un premier temps Clawdbot en référence à une créature en art ASCII, il a dû être rebaptisé Moltbot suite à une demande d'Anthropic pour des raisons de marque déposée. Cette transition chaotique a permis à des escrocs de détourner les anciens identifiants sociaux du développeur pour lancer de fausses cryptomonnaies, causant des pertes financières à des tiers. Peter Steinberger a dû intervenir publiquement pour dénoncer ces arnaques qui nuisent à la réputation du logiciel.

Mais le véritable éléphant dans la pièce reste la sécurité des données. Des chercheurs, notamment chez Bitdefender, ont découvert des vulnérabilités critiques dans des déploiements mal configurés, permettant à des tiers d'accéder à des tableaux de bord exposés, de voler des clés API et de lire des historiques de conversations privées. De plus, tout LLM ayant accès à une machine locale est susceptible d'attaques par injection de prompt, où l'IA pourrait être trompée pour exfiltrer des données personnelles. Bien que Moltbot offre un aperçu fascinant de ce que pourraient être les assistants de demain, il reste pour l'instant une expérience réservée aux experts conscients des risques et non un outil grand public prêt à l'emploi sans danger.